Sub:Wikipediaartikel (IQ 150)

Zu einfach? Dann wählen Sie eine kompliziertere Variante.

Zu kompilziert? Dann bist du voll doof, Alter! Aber du kannst ja eine andere Version wählen.

Inhaltsverzeichnis

Wikipediaartikel dienen einer qualifizierten Mehrheit der humanoiden Individuen als source de informacíon. Durch die gezielte Informationsaufnahme eines Wikipediaartikels erlangt das wissensbegierige Subjekt ein Breviarium über das es interessierende Lemma.

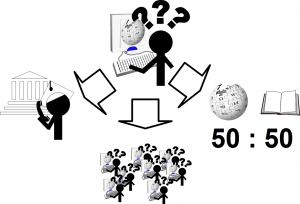

Der Filtrierung des Contextes kommt dabei eine besondere Rolle zugute, da Wikipediaartikel unter dem Prinzip des Freien Wissens zu leiden haben, welches bedeutet, dass Intellektuelle, Subintellektuelle, Koryphäen und tertiäre Experten die Möglichkeit haben, ihre mentalen Leistungen zu koppeln, was zu einem Multiplikatoreffekt des Natriumchlorids in einer warmen, flüssig bis breiigen Speise und der Opazität eines Artikels führt. Die Weisen der Wikipedia erkannten, dass das Differential der Informationskonzentration einen Nulldurchgang hatte. Sie veranstalteten ein Meeting bei Chatroulette mit dem Ziel die Benutzerfreundlichkeit progressiv zu modifizieren. Als Resümee führte Wikipedia 2003 zur Unterstützung des Lesers eine Symbolik ein, welche Aufschluss darüber gibt, welches Reduktionsverfahren am Besten eingesetzt werden sollte: Die Unterscheidung in normale, lesenswerte und exzellente Artikel.

Methode 1: referentielles Multitabbing

Ein recht effizientes Verfahren beim Studium normaler Wikipediaartikel ist das referentielle Multitabbing. Es zeigt sich, dass in den meisten Artikeln ein streng monoton fallender Informationsgehalt ist. Reziprok bedeutet dies, dass der Lead-Text höchste Priorität hat. Jedes Lemma wird somit nur bis zum ersten Uniform Resource Identifier erfasst und das Folgelemma besucht. Diese Methode wird rekursiv angewendet bis die absolute Differenz zwischen subjektiver Wahrnehmung des eigenen Verständnisses und des gewünschten Verständnisses zu einer festgelegten Grenze [math]\epsilon_{Inkomp.}[/math] konvergiert.

Die Vorteile dieses Verfahrens liegen auf der Hand:

- Mehr als 95% des Textes sind unbrauchbar, trivial oder leicht falsifizierbar. Dies wird vermieden.

- Der Leser bleibt aktiv und erhöht somit das Auffassungsvermögen.

- Das zentrale Nervensystem generiert (intrinsisch motiviert) Muster aufgrund einer quantitativ großen Menge an Datenquanten

Methode 2: contextreduzierende Quellenamplifikation

Bei lesenswerten Artikeln empfiehlt sich häufig die contextreduzierende Quellenamplifikation. Empirisch zeigt sich eine Korrelation von über 0,9 zwischen dem Context eines lesenswerten Artikels und einem schwarzen Rechteck. Das Verfahren funktioniert in der Art, dass der komplette Inhalt mit dem stark korrelierenden Rechteck substituiert wird. Der Inhalt lässt sich somit schneller verarbeiten.

Stattdessen wird die Priorität auf die Quellenangaben und Einzelreferenzen gelegt. Lesenswerte Artikel haben eine sehr differenzierte und umfangreiche Auswahl an weiterführenden Uniform Resource Identifiers. Die Verlässlichkeit der Quellenangaben konvergiert hingegen mit der Verlässlichkeit eines partiell siebähnlichen Präservativs. Eine eigene Recherche führt zu analogen Ergebnissen, nur dass die bei Wikipedia stark überdurchschnittlich verbreiteten 404-Verweise und die ebenso praktizierten, stimmungshebenden Verweise direkt ad acta gelegt werden können.

Methode 3: curatives Jauch-Verfahren

Exzellente Artikel haben ein überdurchschnittliches Informationspotential und im Vergleich zu den anderen Lemmas ein marginales Informationsgefälle. Der Anspruch an die Kentnisse des wissensbegierigen Individuums spiegeln das Niveau des Textes wieder: Ein akademischer Grad im jeweiligen Fachgebiet ist von Nöten.

Allerdings lehrt auch hier die Empirie wieder: Beim Median der Leser entstehen drei große, farbneutrale Fragezeichen über dem caput. Da der Wikipedia wichtiger ist, dass eine breite Leserschaft den Netzauftritt annähernd konstant frequentiert besucht als dass die Informationen verständlich und auf gesteigertem Niveau vorhanden sind, gibt sie für exzellente Artikel die Empfehlung des curativen Jauch-Verfahrens.

Beim cura-tiven Jauch-Verfahren werden nach mentaler Aufnahme des Artikelcontextes, welcher mit infinitesimaler Wahrscheinlichkeit verstanden wird, [math]\!\,x[/math] (mit [math]x \in \N \cap \{ x \mid 1 \le x \le 3 \}[/math]) der folgenden Verfahren zum besseren Verständnis ausgeführt:

- 1. universitärer Supportismus

- Bei dieser Methode wird zur Unterstützung ein Kollege eines anderen Institutes, welcher besagten akademischen Grad hat, zu Rate gezogen. Eventuell wird diese Methode rekursiv vom Kontaktierten wiederholt, was oft in Methode 2 des curativen Jauch-Verfahrens mündet.

- 2. kollektives Kollateralversagen

- Entweder folgt dieses Verfahren unmittelbar auf den universitären Supportismus oder es wird - heutzutage immer höher favorisiert - als Erstes eingesetzt. Dabei begibt sich der subintelligente Neugierige in Internetforen und gibt mit dem Hinweis: "Kann mir einer mit <ENTER SUBJECT HERE> weiterhelfen? Ich hatte das bei der Wikipetia ergooglet und nicht verstanden lol." seinen Wissensdrang preis. Die drei Antworten mit der höchsten stochastischen Wahrscheinlichkeit - "Ha! Erster!", "Google ist dein Freund", "Mein Gott, kann den hier NIEMAND die Suche benutzen?" - resultieren aus der Tatsache, dass auch die meisten anderen Menschen ( [math]\approx \forall[/math]) mit einem exzellenten Artikel mental überfordert sind.

- 3. Seriösitätsquantifizierung

- Dieses Verfahren wird im folgenden Abschnitt näher behandelt.

Methode 4: Seriösitätsquantifizierung

Ursprünglich war die Seriösitätsquantifizierung Teil des curativen Jauch-Verfahrens. Mit streng monoton wachsender Importanz (Ordinate) gegenüber der Zeit (Abszisse) dieser Methode und der Tatsache, dass diese eine singuläre Universalität besitzt, wurde diese Selektionsmethode nach dem Prinzip "survival of the fittest" als unabhängig anerkannt ( [math]\rightarrow[/math] siehe auch: Unabhängigkeitserklärung der Seriösitätsquantifizierung von 1998).

Diese Methode basiert auf der philosophischen Hypothese: "Es gibt andere Quellen als die Wikipedia." Es zeigte sich zu schweren Krisenzeiten im Zeitalter des jungen Internets, gerade als Internetverbindungen nahe bei der Stabilitätsgrenze (Phasenrand [math]5^\circ \le \varphi \le 10^\circ[/math]) betrieben wurden, dass diese vage Vermutung eine verifizierbare, reelwertige Lösung besitzt: 42.

Eine andere, weit verbreitete und trivialere Lösung ist der unmittelbare Vergleich mit einer gebundenen Papiermasse. Naheliegend ergibt sich die Fragestellung "Was ist seriöser? Wikipedia oder ein Buch mit weißen Seiten?". Durch die anderen Methoden zeigte sich, dass ein Lemma bis auf den ersten Satz Quarkmechanisch betrachtet werden könne. Der weitere Inhalt gleicht einem schwarzen Rechteck und/oder ist für den geübten Leser nicht ergiebig und als Quelle wird bei vielen Lemmata 404 angegeben. Auf Cellulose gebündeltes Wissen gewinnt somit an Bedeutung und Seriösität. Ein populäres Ergebnis der Seriösitätsquantifizierung ist somit die Füllstandserhöhung der digitalen Recyclingstation mit Wikipediaartikeln.